Mesurer le succès et analyser les résultats

Cet article vous aidera à :

- Rassembler suffisamment de données avant de décider de mettre fin à une expérience.

- Interpréter les résultats des expériences gagnantes, perdantes et non concluantes.

Une fois que vous avez démarré votre expérience, vous pouvez consulter les résultats dans la vue Détails des expériences créatives. Bien que vous puissiez commencer à vérifier les résultats immédiatement, nous recommandons d'attendre au moins deux semaines pour recevoir des données avant de tirer des conclusions. Vous devez laisser votre expérience se dérouler suffisamment longtemps pour collecter suffisamment de données afin d'avoir un niveau de confiance élevé dans les résultats.

Trouver la page des détails de l'expérienceLien direct vers Trouver la page des détails de l'expérience

- Dans One Platform, cliquez sur votre compte sur la page d'accueil. Ensuite, allez à la page Campagnes > Expériences depuis le menu de navigation à gauche.

- Localisez ou recherchez votre expérience dans la liste Aperçu.

- Cliquez sur le nom de l'expérience pour afficher la page Détails.

Dans la carte de résumé en haut, vous trouverez les éléments suivants :

- Nom de l'expérience et hypothèse

- Options pour terminer l'expérience

- Le nombre de jours de fonctionnement

- Audience ciblée dans l'expérience

Pour plus d'informations sur les paramètres de l'expérience ou pour modifier les allocations, cliquez sur Paramètres.

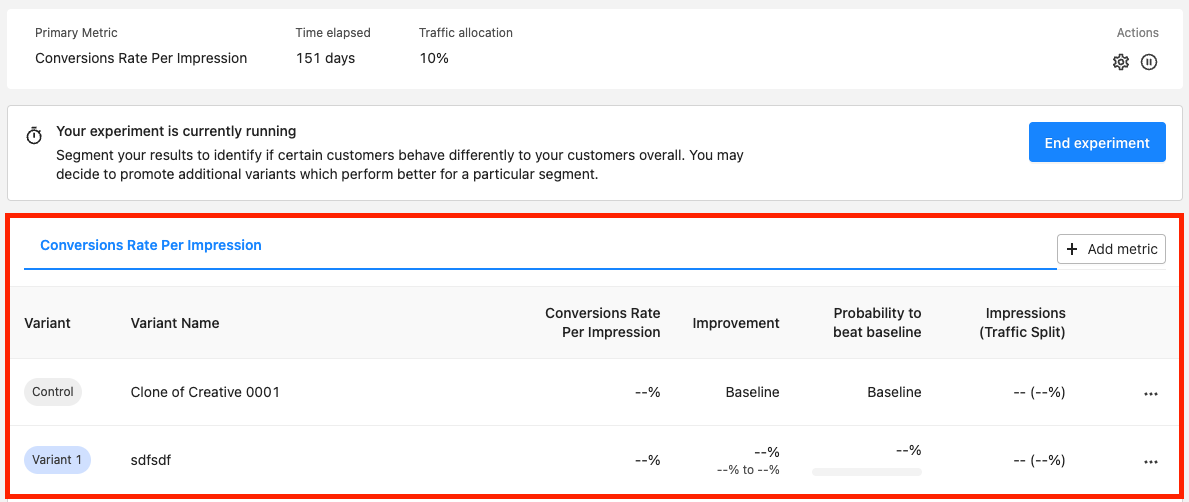

En dessous de la carte de résumé en haut, vous verrez les résultats de l'expérience. Au fur et à mesure que votre expérience se déroule, vous pouvez surveiller et comparer ses performances par rapport à votre création originale. En examinant ces résultats, vous pouvez voir si vos résultats sont significatifs et fiables. Nous recommandons de faire fonctionner votre expérience jusqu'à ce qu'au moins une variante ait une probabilité de 95 % de battre la variante de référence originale.

Rokt recommande de faire fonctionner votre expérience jusqu'à ce qu'au moins une variante ait une probabilité de 95 % (ou moins de 5 %) de battre la variante de référence originale.

Interprétation des résultats de votre expérienceLien direct vers Interprétation des résultats de votre expérience

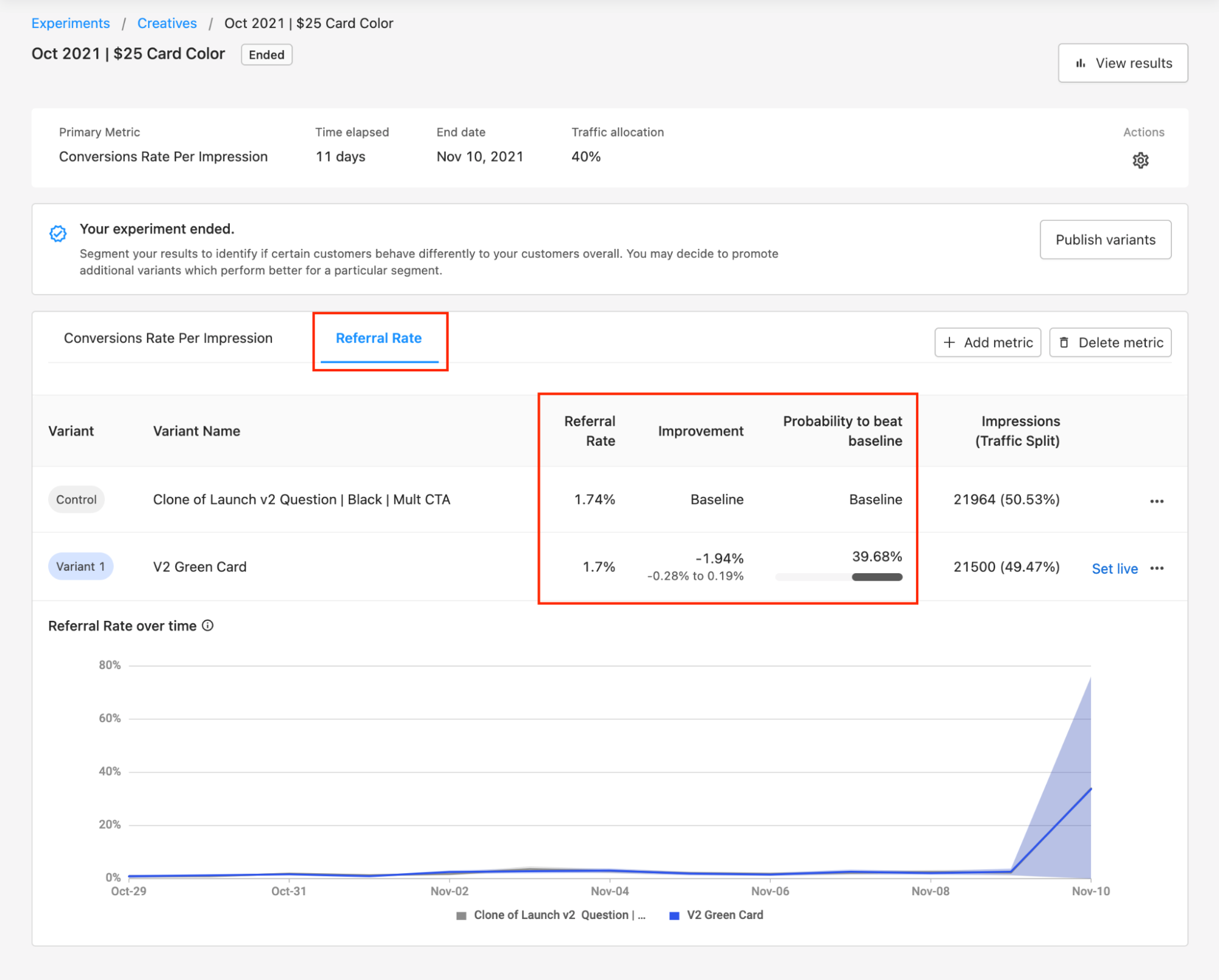

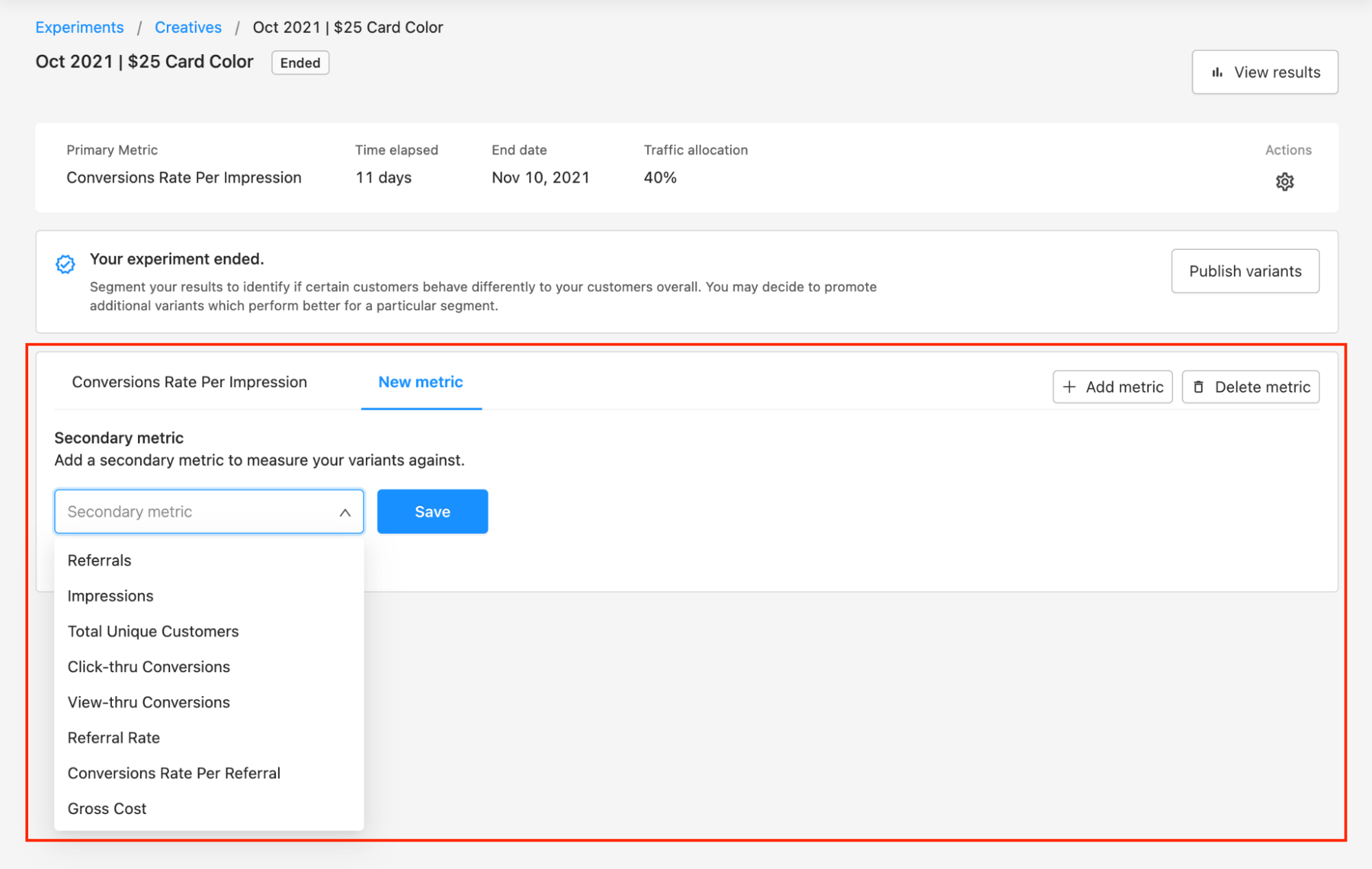

En haut du tableau des résultats, vous verrez la Métrique sélectionnée. Cette Métrique est utilisée pour calculer la probabilité de chaque variante de surpasser la variante de référence originale. Vous pouvez également vouloir voir les résultats de chaque variante par rapport à d'autres métriques. Des métriques supplémentaires aident à identifier les impacts potentiels non intentionnels sur l'expérience.

Vous pouvez voir d'autres métriques en cliquant sur + Ajouter une métrique en haut du tableau des résultats. Vous pouvez ensuite choisir les métriques supplémentaires que vous souhaitez voir et cliquer sur Enregistrer. Pour supprimer les métriques que vous ne souhaitez plus voir, cliquez sur Supprimer la métrique.

Nous recommandons généralement d'évaluer toutes les métriques secondaires pour rechercher des avertissements indiquant que vous impactez négativement d'autres métriques.

AméliorationLien direct vers Amélioration

Cette métrique mesure la différence relative de performance entre les variantes de test et l'original pour la métrique sélectionnée. Utilisez les onglets en haut du tableau des résultats pour basculer entre les métriques.

Probabilité de battre la référenceLien direct vers Probabilité de battre la référence

Ce métrique montre la probabilité qu'une variante va performer mieux que la variante de référence. Si une variante dépasse l'original de plus de 95 %, alors le résultat est probablement fiable et vous pouvez la sélectionner comme gagnante. Il est possible d'avoir plus d'une variante qui dépasse la référence.

Nous recommandons d'attendre que la probabilité de battre la référence atteigne 95 % avant de déployer une variante expérimentale. Déployer plus tôt est possible, mais risqué car vous travaillerez avec des données incomplètes.

Intervalle crédibleLien direct vers Intervalle crédible

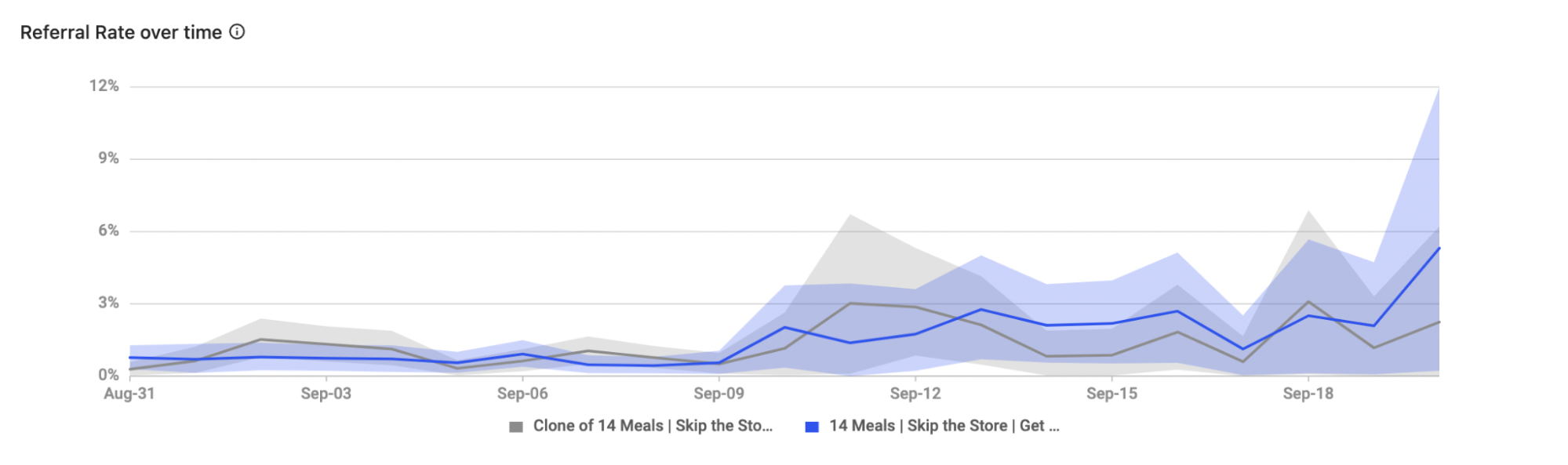

L'intervalle crédible mesure l'incertitude autour de l'amélioration et affiche une gamme de valeurs où la performance pour le métrique sélectionné se situe réellement. Sous les données et l'analyse de votre expérience se trouve un graphique montrant l'intervalle crédible pour chacune de vos variantes. Cela visualise comment vos variantes ont performé jusqu'à présent par rapport au métrique sélectionné dans votre tableau de résultats. Vous pouvez voir quel métrique a été sélectionné en regardant le titre du graphique.

Le graphique commence large, indiquant une plus grande incertitude quant à la performance de chaque variante. À mesure que l'expérience collecte plus de données au fil du temps, l'intervalle se rétrécit pour montrer que la certitude augmente. Recherchez un chevauchement minimal ou nul entre les différentes lignes (variantes) sur votre graphique pour avoir plus de confiance dans les résultats de votre expérience.

Décider de conclure une expérienceLien direct vers Décider de conclure une expérience

Nous recommandons de suivre quelques règles lors de l'interprétation des résultats de votre expérience et de décider de mettre fin à l'expérience.

- Attendez que l'expérience ait duré au moins deux semaines. Cela garantit que l'expérience a duré suffisamment longtemps pour recueillir suffisamment de données.

- Prenez le temps d'analyser les résultats et d'en apprendre davantage sur vos clients. Plus vous approfondissez les résultats et passez de temps à interpréter les données, plus vous pourrez en apprendre sur vos clients au-delà des variantes qui gagnent et perdent globalement.

Que faire lorsque vous avez un gagnant ?Lien direct vers Que faire lorsque vous avez un gagnant ?

Il existe plusieurs scénarios possibles lorsqu'il s'agit d'identifier la ou les variantes les plus performantes dans votre expérience.

-

L'original est le gagnant. Il est possible que toutes vos variantes expérimentales performent moins bien que la variante de référence originale (toutes ont <95% de probabilité de battre la référence). Dans cette situation, il est préférable de laisser votre expérience actuelle en ligne et de mettre fin à l'expérience. Le résultat est peu susceptible de changer et votre temps serait mieux employé sur une nouvelle expérience.

Notez que ce n'est pas un mauvais résultat ou une expérience échouée ! Vous avez acquis des informations précieuses sur le comportement de vos clients qui peuvent être exploitées pour de futurs tests.

-

Une variante spécifique est le gagnant. Il y a suffisamment de données pour conclure qu'une de vos variantes surpasse l'original pour votre indicateur de succès principal (c'est-à-dire qu'une variante spécifique a 95% ou plus de probabilité de battre la référence). Il est sûr de mettre fin à l'expérience et de promouvoir cette variante pour qu'elle fonctionne comme une variante autonome sur votre page. Vous pouvez souhaiter mettre en pause ou supprimer la variante originale si les résultats de l'expérience montrent que la variante testée performe mieux. Si vous préférez une transition plus lente et ne souhaitez pas mettre en pause ou supprimer la variante originale, l'algorithme d'apprentissage automatique de Rokt apprendra au fil du temps et montrera la meilleure option pour chaque client.

-

Plusieurs variantes battent l'original. Vous pouvez constater que plus d'une de vos variantes testées performe mieux que l'original (c'est-à-dire que plusieurs variantes ont 95% ou plus de probabilité de battre la référence). Une fois qu'il y a suffisamment de données pour conclure que certaines de vos variantes performent mieux que l'original, vous devriez avoir suffisamment de données pour conclure laquelle est la meilleure absolue. Vous pouvez choisir de promouvoir uniquement la variante avec la probabilité la plus élevée de battre la référence, ou plusieurs variantes et laisser l'algorithme d'apprentissage automatique de Rokt déterminer quelle est la meilleure option à montrer à chaque client.